¿Qué es un web crawler? Cómo las arañas web optimizan Internet

Los web crawlers son la razón por la que motores de búsqueda como Google, Bing, Yahoo y DuckDuckGo siempre proporcionan resultados de búsqueda nuevos y actualizados. Estos bots deambulan por la web como arañas, recopilando información y organizándola en índices. ¿En qué ámbitos se utilizan los rastreadores web y qué tipos existen en Internet?

- Mejora tu posicionamiento en Google sin necesidad de una agencia

- Responde los comentarios y publica en redes sociales más rápido

- Sin necesidad de conocimientos de SEO o marketing online

¿Qué es un web crawler?

Los web crawlers son bots que buscan datos en Internet, analizan el contenido y guardan la información en índices y bases de datos para mejorar el rendimiento de los motores de búsqueda. Además, las arañas web recopilan datos de contacto y perfiles con fines de marketing.

Como estos bots de motores de búsqueda se mueven de forma tan precisa por todas las ramificaciones de Internet en busca de información, en español se los conoce como arañas web o rastreadores web. El primer web crawler se llamaba World Wide Web Wanderer y se basaba en el lenguaje de programación PERL. Este rastreador, implementado en 1993, medía el crecimiento del entonces todavía joven Internet y organizaba los datos recopilados en Wandex, el primer índice de Internet.

Los web crawlers son especialmente importantes para la optimización de motores de búsqueda o SEO (del inglés search engine optimization). Para las empresas, es fundamental familiarizarse con los diferentes tipos y funciones de arañas web para poder ofrecer un contenido optimizado para SEO en línea.

¿Cómo funciona un web crawler?

Al igual que los bots sociales y los chatbots, los web crawlers están compuestos por un código de algoritmos y scripts que establece unos comandos e instrucciones claros. El crawler repite de forma autónoma y continua las funciones definidas en el código.

Los web crawlers se desplazan por Internet a través de los hipervínculos que aparecen en las páginas web existentes. Evalúan palabras clave y hashtags, indexan el contenido y las URL de cada página web, copian páginas web y abren todos o solo algunos de las URL que encuentran para analizar nuevas páginas web. Además, comprueban que los enlaces y los códigos HTML estén actualizados.

Mediante el uso de herramientas especiales de análisis web, los web crawlers pueden evaluar diversos datos, como los enlaces clicados y las páginas visitadas, así como recopilar información en términos de minería de datos o compararlos de forma dirigida (por ejemplo, para portales de comparación).

Cada vez con más frecuencia, los motores de búsqueda y los crawlers especializados utilizan inteligencia artificial y procesamiento del lenguaje natural (NLP), para comprender los contenidos web no solo desde el punto de vista técnico, sino también a nivel semántico. De este modo, los web crawlers modernos pueden analizar, por ejemplo, las relaciones semánticas, la relevancia temática o la calidad del texto.

¿Qué tipos de web crawler existen?

Hay varios tipos de arañas web, que difieren en su enfoque y alcance.

Arañas web de motores de búsqueda

El tipo de web crawler más antiguo y común son los rastreadores web de Google u otros motores de búsqueda como Yahoo, Bing o DuckDuckGo, que examinan, recopilan e indexan el contenido web y, de este modo, optimizan el alcance y la base de datos del motor de búsqueda. Los web crawlers más famosos son los siguientes:

- GoogleBot (Google)

- Bingbot (Bing)

- DuckDuckBot (DuckDuckGo)

- Baiduspider (Baidu)

- Yandex Bot (Yandex)

- Sogou Spider (Sogou)

- Exabot (Exalead)

- GPTBot (OpenAI)

- ClaudeBot (Anthropic)

Arañas web personalizadas

Estos pequeños web crawlers presentan una funcionalidad muy simple y son utilizados por las empresas para realizar tareas concretas. Por ejemplo, monitorean la frecuencia de determinados términos de búsqueda o la disponibilidad de ciertas URL.

Arañas web comerciales

Se trata de soluciones de software complejas desarrolladas por proveedores que las comercializan como herramienta. Ofrecen más servicios y funciones, además de ahorrar a las empresas el tiempo y el dinero que requeriría desarrollar sus propios web crawlers.

Arañas web en la nube

También hay arañas web que no almacenan los datos en servidores locales, sino en una nube y que, en su mayoría, son comercializadas como servicio por empresas de software. Gracias a su independencia de los dispositivos locales, permiten utilizar las herramientas de análisis y las bases de datos desde cualquier dispositivo mediante unas credenciales de inicio de sesión. Asimismo, la aplicabilidad es escalable.

Arañas web de escritorio

También puedes ejecutar pequeños web crawlers en tu propio PC u ordenador portátil. Estas arañas web son económicas, pero tienen un uso muy limitado y, por lo general, solo pueden evaluar pequeñas cantidades de datos y páginas web.

Arañas web móviles

Las arañas web móviles analizan las páginas web tal y como se muestran en smartphones y tablets. Desde la implantación del mobile-first indexing (indexación orientada a móviles) por parte de Google, son determinantes para la posición en los buscadores. Permiten, por ejemplo, detectar problemas de visualización y valorarlos en consecuencia.

AI crawler

Los AI crawlers son web crawlers basados en inteligencia artificial. Las empresas los utilizan para analizar y evaluar contenidos de la web o para entrenar grandes modelos de lenguaje (LLM). A diferencia de los bots de búsqueda clásicos, no solo indexan páginas, sino que también comprenden los contenidos a nivel semántico, extraen conocimiento y lo aplican para mejorar los modelos.

Grow your business with managed Google Ads and our expert guidance.

¿Cómo funcionan los web crawlers?

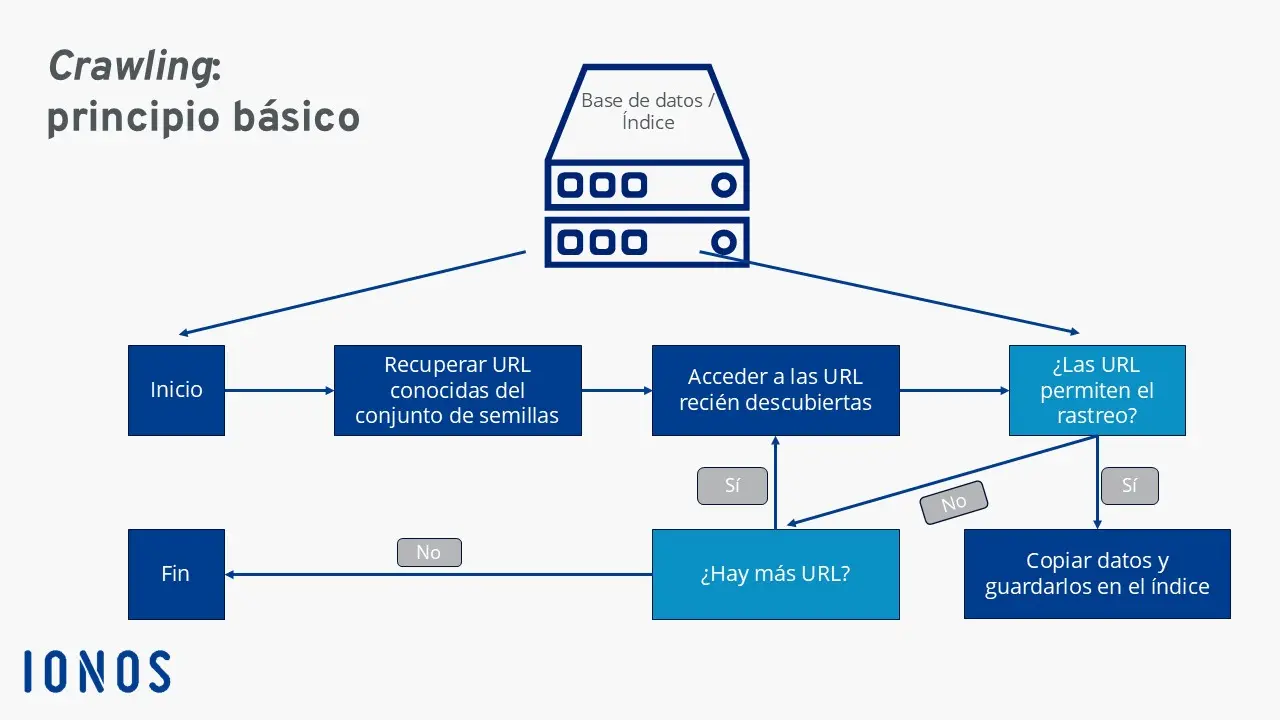

El procedimiento seguido por un web crawler consta de varios pasos:

- Frontera de rastreo: los motores de búsqueda emplean una estructura de datos llamada frontera de rastreo (en inglés, crawl frontier) para determinar si las arañas web deben buscar nuevas URL a partir de mapas de sitio y páginas ya indexadas, o solo rastrear ciertos contenidos específicos.

- Conjunto de semillas: los web crawlers reciben un conjunto de semillas del motor de búsqueda o del cliente. Se trata de una lista una lista de URL conocidas o que deben analizarse. El conjunto se basa en bases de datos, mapas de sitio e índices anteriores. Los web crawlers lo exploran hasta que se repiten en bucle o alcanzan enlaces muertos.

- Elaboración del índice: a partir del análisis del conjunto de semillas, los web crawlers evalúan el nuevo contenido web y añadirlo al índice. De esta manera, actualizan el contenido obsoleto o eliminan del índice las URL y los enlaces que ya no existen.

- Frecuencia de rastreo: aunque las arañas web exploran constantemente la web, los programadores pueden determinar con qué frecuencia deben visitar y evaluar las URL. Para ello, analizan el rendimiento de las páginas, la frecuencia de las actualizaciones y el tráfico de datos. Con estos datos, los programadores definen la demanda de rastreo.

- Gestión de indexación: los administradores pueden limitar las visitas a una página web por parte de los rastreadores web mediante los llamados protocolos robots.txt o las etiquetas HTML

nofollow. Así, al acceder a una URL, los web crawlers obtienen instrucciones para evitar cierta página web o excluir algunos datos de la evaluación.

Desde 2020, Google ya no trata el atributo nofollow como una instrucción estricta, sino solo como una sugerencia para la valoración de enlaces. Esto significa que Google puede rastrear e incluso indexar enlaces con nofollow. Para los administradores de páginas web, esto implica lo siguiente: si quieres excluir realmente contenido del rastreo, debes utilizar además el archivo robots.txt o la etiqueta noindex.

Ventajas de los web crawlers

✓ Económicos y eficaces: los web crawlers asumen tareas de análisis costosas y que conllevan mucho tiempo. Además, pueden escanear, analizar e indexar el contenido web de forma mucho más rápida, económica y completa que los humanos.

✓ Fácil de usar y gran alcance: los web crawlers pueden implementarse rápida y fácilmente y garantizan que los datos se recopilen y analicen de forma continuada y completa.

✓ Mejora de la reputación online: con los web crawlers, puedes optimizar tu propio marketing online, ya que te permiten ampliar tu propio abanico de clientes y centrarte en él. Además, mejoran la reputación de tu empresa captando patrones de comunicación en las redes sociales.

✓ Publicidad dirigida: a través de la minería de datos y la publicidad dirigida, es posible dirigirse a grupos de clientes concretos. Las páginas web con una frecuencia de rastreo alta aparecen en las posiciones superiores de los motores de búsqueda y reciben más visitas.

✓ Evaluación de datos de empresas y clientes: las empresas pueden utilizar web crawlers para evaluar y analizar los datos de los clientes y las empresas disponibles en Internet y utilizarlos para su propia estrategia corporativa y de marketing.

✓ Optimización SEO: al evaluar los términos de búsqueda y las palabras clave, se pueden definir las palabras clave en las que centrarse, reduciendo la competencia y aumentando las visitas a la página.

Otros posibles usos son:

- Realizar un seguimiento continuo de los sistemas para encontrar puntos débiles

- Archivar páginas web antiguas

- Comparar páginas web actualizadas con versiones anteriores

- Encontrar y eliminar enlaces muertos

- Investigar el volumen de búsqueda de palabras clave

- Detectar errores ortográficos y otro contenido incorrecto

Cómo aumentar la frecuencia de rastreo de una página web

Si quieres que tu página web ocupe un lugar destacado en los motores de búsqueda y que las arañas web lo visiten con regularidad, debes ponérselo fácil a los bots para que lo encuentren. Las páginas web con una frecuencia de rastreo alta gozan de una mayor prioridad en los motores de búsqueda. Para que los web crawlers encuentren un página web con más facilidad, los siguientes factores son decisivos:

- La página web contiene varios enlaces y también está vinculada a otras páginas web. De esta manera, los web crawlers no solo lo encuentran a través de los enlaces, sino que también lo consideran un nodo de redirección y no solo una vía unidireccional.

- El contenido de la página web está siempre actualizado y al día, lo que se aplica al contenido, los enlaces y el código HTML.

- Se garantiza la accesibilidad del servidor.

- El tiempo de carga de la página web es reducido.

- No hay enlaces ni contenido duplicados o redundantes.

- El mapa del sitio, el archivo robots.txt y los encabezados de respuesta HTTP proporcionan a la araña web información importante sobre la página web.

Arañas web y raspadores web: ¿en qué se diferencian?

Aunque suelen confundirse, los web crawlers y los raspadores no son el mismo tipo de bot. Mientras que las arañas web buscan principalmente contenido para organizarlo en índices y evaluarlo, la principal tarea de los raspadores es extraer datos de las páginas web mediante el raspado.

Los web crawlers presentan muchas similitudes con los raspadores web: por ejemplo, también suelen utilizar el raspado a la hora de copiar y guardar el contenido web. Sin embargo, sus funciones principales son acceder a los URL, analizar el contenido e indexar los nuevos enlaces y URL.

Los raspadores, por su parte, se encargan principalmente de visitar URL concretas, extraer datos específicos de las páginas web y almacenarlos en bases de datos para su uso posterior.