Como configurar WordPress robots.txt para indexação de páginas

Nem todos os diretórios e subpáginas do seu site precisam ser encontrados pelos mecanismos de busca convencionais, pois nem todos são relevantes para o público. O arquivo robots.txt no WordPress define quais subpáginas serão exploradas por crawlers e quais serão ignoradas. Ao fazer essa distinção, você poderá melhorar consideravelmente a colocação do seu site nas buscas. Entenda como funciona o WordPress robots.txt e como você pode otimizar este arquivo.

- O que é WordPress robots.txt?

- Para que serve o WordPress robots.txt?

- WordPress robots.txt automático

- O que incluir em um arquivo WordPress robots.txt

- Como configurar WordPress robots.txt manualmente

- Plugins para criar um arquivo WordPress robots.txt

- Como testar as modificações

- Conclusão: WordPress robots.txt otimiza e protege seu site

Nomes de domínio por US$ 1

Registre ótimos TLDs por menos de US$ 1 no primeiro ano. Esperar para quê? Garanta seu nome de domínio preferido hoje mesmo.

O que é WordPress robots.txt?

Robôs (bots) chamados crawlers estão constantemente vasculhando a internet, à procura de sites. Estes programas, utilizados pelos diversos mecanismos de busca, tem a missão de indexar o maior número possível de páginas e subpáginas, assim incluindo-as nos resultados das pesquisas. Para que os crawlers analisem corretamente o seu site, você precisa orientá-los, garantindo que eles só encontrem as páginas destinadas ao público. Isso evita a indexação de conteúdos irrelevantes.

Para controlar o caminho dos crawlers, você pode usar o arquivo robots.txt. No WordPress e em outros CMS, esse arquivo determina quais seções do site devem ser indexadas por crawlers e quais não. Modificando o robots.txt, você pode bloquear ou permitir robôs específicos, além de definir precisamente quais mecanismos de busca encontrarão quais conteúdos e os incluirão nos resultados das pesquisas. Cada domínio tem seu crawl budget: um número limitado de páginas indexadas diariamente pelos crawlers de um determinado mecanismo de busca. Por isso, é muito importante destacar páginas principais e excluir subpáginas irrelevantes.

Você está a poucos cliques do domínio que você deseja. Registre seu domínio com a IONOS com toda a praticidade e receba o melhor suporte, diversos recursos de segurança e uma caixa de e-mail com 2GB de espaço.

Para que serve o WordPress robots.txt?

No WordPress, o robots.txt determina precisamente quais conteúdos são indexados por mecanismos de busca e quais são ignorados, o que pode ser muito vantajoso para quem tem um site. Por exemplo: sua página inicial deve conseguir a melhor colocação possível nas buscas relacionadas. Por outro lado, uma subpágina com informações técnicas ou jurídicas não precisa ser indexada. Comentários e publicações arquivadas também não agregam nenhum valor à busca e, pelo contrário, podem até prejudicar os resultados — como nos casos em que os mecanismos de busca detectam conteúdo duplicado no site e o avaliam negativamente. Com o arquivo robots.txt no WordPress, você evita casos assim e direciona os diversos crawlers para as seções do seu site que realmente devem ser encontradas.

WordPress robots.txt automático

O próprio WordPress gera um robots.txt automaticamente, já criando uma base importante. Mas esse arquivo automático é simples demais e, por isso, serve apenas como ponto de partida. Ele contém o seguinte código:

User-agent: *

Disallow: /wp-admin/

Disallow: /wp-includes/

O “User-agent” descrito na primeira linha refere-se ao crawler. O asterisco significa que qualquer mecanismo de busca pode enviar bots para o site. Em princípio, isso é recomendável, pois assim seu site será encontrado com mais frequência. O comando “Disallow” impede o acesso dos crawlers aos diretórios especificados (neste caso, à área de administração e ao diretório de arquivos internos do WordPress). O robots.txt bloqueia essas seções para mecanismos de busca, pois as páginas nelas contidas não têm nenhuma utilidade para os visitantes. Para ter certeza de que somente você acessará essas áreas, proteja-as configurando uma senha forte.

Como administrador de um site, você pode proteger seu login no WordPress com o arquivo .htaccess.

O que incluir em um arquivo WordPress robots.txt

Obviamente, mecanismos de busca como o Google devem continuar encontrando seu site com facilidade. Porém serviços maliciosos ou suspeitos, como o DuggMirror, não devem. Você também pode bloqueá-los usando o robots.txt no WordPress. Além disso, você deve excluir da indexação páginas que têm pouca ou nenhuma relevância para buscas (como themes utilizados, informações jurídicas, etc.). Plugins também não devem ser indexados, não só por serem irrelevantes para o público, mas também por motivos de segurança. Caso algum plugin tenha uma falha de segurança, sua indexação pode permitir que invasores encontrem e afetem seu site.

Na maioria dos casos, os dois comandos mencionados anteriormente já são suficientes para usar o robots.txt no WordPress de forma adequada. “User-agent” determina a quais bots o comando se aplicará. Assim, você pode definir exceções para mecanismos de busca específicos, ou criar regras básicas. “Disallow” proíbe o acesso de crawlers a uma determinada página ou subpágina. O terceiro comando, “Allow”, geralmente não é importante, pois o acesso é permitido por padrão. Você só precisará usá-lo caso deseje bloquear uma página, mas permitir o acesso às subpáginas dela.

Conheça o jeito mais rápido de conseguir o próprio site: com o WordPress Hosting da IONOS, você aproveita uma série de vantagens. Além de domínios gratuitos permanentes, o serviço inclui SSD, HTTP/2 e gzip. Escolha o plano mais adequado às suas necessidades.

Como configurar WordPress robots.txt manualmente

Para uma configuração mais personalizada, você mesmo pode modificar o arquivo robots.txt do seu site WordPress. Basta seguir alguns passos simples:

- Passo 1: Em qualquer editor de texto, crie um arquivo vazio chamado “robots.txt”.

- Passo 2: Carregue esse arquivo no diretório-raiz do seu domínio.

- Passo 3: Edite o arquivo por SFTP ou carregue um novo arquivo de texto.

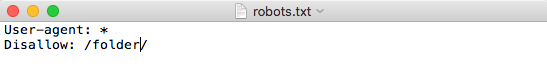

Com os comandos que apresentamos acima, você controla quais regras e exceções se aplicam ao seu site. Para bloquear o acesso a uma pasta específica, escreva o código abaixo, substituindo “folder” pelo nome da pasta:

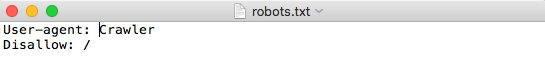

Para impedir o acesso de um determinado bot ao seu site, insira o seguinte comando, trocando “Crawler” pelo nome do bot:

Plugins para criar um arquivo WordPress robots.txt

Você também pode criar e editar um arquivo WordPress robots.txt usando um plugin de SEO. Isso talvez seja ainda mais fácil, pois tudo é feito com praticidade e segurança pelo Painel. Um plugin muito popular para indexação é o Yoast SEO. Estes são os passos a serem tomados:

- Passo 1: Antes de tudo, instale e ative o plugin.

- Passo 2: Permita que o plugin altere configurações avançadas. Para isso, vá para “SEO” > “Dashboard” > “Features” e, no item “Advanced settings pages”, clique na opção “Enabled”.

- Passo 3: Depois da autorização, faça as alterações pelo Painel, acessando “SEO” > “Tools” > “File editor”. Nesse editor de arquivos, você pode criar e editar diretamente um novo arquivo robots.txt no WordPress. As alterações têm efeito imediato.

Como testar as modificações

Neste momento, você já configurou seu site, definiu suas regras e, pelo menos em tese, bloqueou alguns crawlers e tornou invisíveis certas subpáginas. Mas como ter certeza de que todas as suas alterações funcionaram? Para checar as modificações, use o Google Search Console. Nessa ferramenta, do lado esquerdo, no item “Crawl”, você encontra o “robots.txt Tester”. Ali você deve inserir o endereço das suas páginas e subpáginas, para ver se são encontradas ou estão bloqueadas. A indicação “allowed”, em verde, na borda inferior direita, indica que os crawlers encontram e consideram a página. Já a “disallowed”, em vermelho, mostra que a página não é indexada.

Conclusão: WordPress robots.txt otimiza e protege seu site

No WordPress, o robots.txt é um método simples e eficaz para determinar quais partes do site poderão ser encontradas, e por quem. Se você já usa um plugin de SEO, como o Yoast, o jeito mais fácil é fazer as alterações pelo próprio plugin. Se não, você também pode criar e editar o arquivo manualmente, sem grandes dificuldades.

No IONOS Digital Guide você encontra uma série de dicas úteis sobre o WordPress. Ajudamos você a evitar os erros mais comuns no WordPress, ensinamos como deixar o WordPress mais rápido e explicamos tudo sobre o WordPress Gutenberg. Nosso guia oferece respostas para todo tipo de dúvida.