Tokens de IA: Definição, funcionamento e cálculos

Tokens de IA representam a menor unidade linguística necessária para que modelos de inteligência artificial processem e interpretem textos. Por meio da AI tokenization, a linguagem é dividida nesses blocos fundamentais, permitindo a análise e a geração de textos. Ferramentas como o OpenAI Tokenizer facilitam a identificação dos tokens de um texto de forma rápida e eficiente.

Definição: O que são tokens de IA?

Artificial Intelligence Tokens, ou tokens de IA, são as menores unidades de dados utilizadas por modelos como ChatGPT, LLaMA 2 e Copilot. Eles são essenciais para o processamento, a interpretação e a geração de textos, pois somente ao dividir um texto em tokens é que a inteligência artificial consegue compreendê-lo e fornecer as respostas adequadas aos prompts dos usuários. Tokens de IA podem representar palavras inteiras, partes de palavras, sinais de pontuação e até emojis.

O número de tokens gerado a partir de um texto depende de vários fatores. Além do comprimento do texto, a linguagem utilizada e o modelo de IA também influenciam essa contagem. Se você estiver utilizando uma API como a ChatGPT API, a quantidade de tokens consumidos afeta diretamente os custos da solicitação. Normalmente, as aplicações de IA cobram pelos tokens utilizados individualmente.

- Online em segundos

- Aumente seu crescimento com marketing de IA

- Economize tempo e recursos

Como funciona a AI tokenization?

O processo pelo qual um modelo de IA converte um texto em tokens é chamado de AI tokenization, ou tokenização de IA. Esse passo é essencial porque os Large Language Models (LLMs) precisam que a linguagem natural seja transformada em um formato que possa ser analisado computacionalmente. A tokenização é a base para a interpretação de textos, o reconhecimento de padrões e a geração de respostas. Sem esse processo, a IA não conseguiria entender os significados e as relações entre palavras. A conversão de texto em tokens ocorre em várias etapas, como mostrado a seguir:

- Normalização: O modelo de IA primeiro converte o texto para uma forma padronizada, reduzindo sua complexidade e variação. Durante essa etapa, todas as letras são transformadas para minúsculas, caracteres especiais são removidos e, em alguns casos, as palavras são reduzidas às suas formas básicas.

- Divisão do texto em tokens: Em seguida, a IA fragmenta o texto em tokens, ou seja, em unidades linguísticas menores. O modo como o texto é dividido depende da complexidade e do treinamento do modelo. Por exemplo, a frase “IA revoluciona a pesquisa de mercado” foi dividida em 11 tokens no GPT-3, 9 tokens no GPT-3.5 e GPT-4, e apenas 8 tokens no GPT-4o.

- Atribuição de valores numéricos: Cada token de IA recebe um valor numérico único, conhecido como Token ID. Essas IDs compõem o vocabulário da inteligência artificial, contendo todos os tokens conhecidos pelo modelo.

- Processamento dos tokens pela IA: O modelo de linguagem analisa a relação entre os tokens para identificar padrões e prever ou gerar respostas. Essas previsões são baseadas em probabilidades. O modelo de IA analisa o contexto e determina cada novo token com base nos tokens anteriores.

- Uma plataforma para os modelos de IA mais avançados

- Preços justos e transparentes baseados em tokens

- Sem dependência de fornecedor com código aberto

Como calcular os tokens de um texto?

A forma como os tokens são gerados por uma IA pode ser compreendida com o uso de tokenizadores, que fragmentam os textos nas menores unidades processáveis. Essas ferramentas utilizam algoritmos específicos que seguem os padrões do treinamento e da arquitetura do modelo de IA.

Além de exibir a quantidade total de tokens, os tokenizadores podem fornecer informações detalhadas sobre cada token individual, incluindo a Token ID correspondente. Isso permite não apenas estimar custos com mais precisão, mas também otimizar a eficiência da comunicação com modelos de IA.

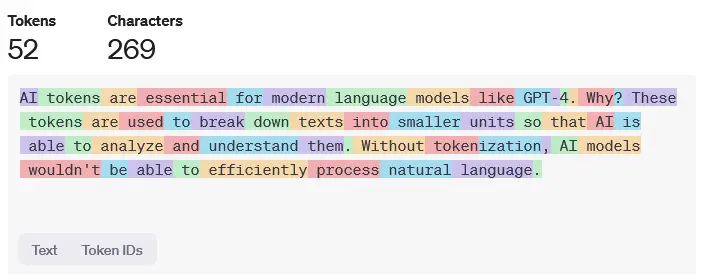

Um exemplo de tokenizador gratuito e acessível é o OpenAI Tokenizer, projetado para os modelos ChatGPT mais recentes. Basta colar ou digitar um texto na área de entrada, e a ferramenta destacará visualmente os tokens individuais.

O limite máximo de texto processado depende da capacidade de tokens do modelo utilizado. O GPT-4, por exemplo, pode lidar com até 32.768 tokens por solicitação.

Exemplo de tokens de IA e tokenization

Para ilustrar como funciona a AI tokenization, utilizamos um exemplo de texto curto:

Os tokens de IA são essenciais para modelos de linguagem modernos como o GPT-4. Mas por quê? Eles dividem os textos em unidades menores, permitindo que a IA os analise e compreenda. Sem a tokenização, os modelos de IA não seriam capazes de processar a linguagem natural de forma eficiente.

O modelo GPT-4o divide esse texto de 285 caracteres em 61 tokens, como mostrado abaixo: